Seq2seq とは

本気 で 叱っ て くれる 人 恋愛Sequence To Sequence ( Seq2Seq ) - アルゴリズム解説 . Sequence to sequence ( Seq2Seq )の技術を紹介します。. 機械学習界隈ではブレイクスルーな技術として GAN や VAE が話題となりました。. 今回解説するSeq2Seqもブレイクスルーといわれる技術の1つです。.

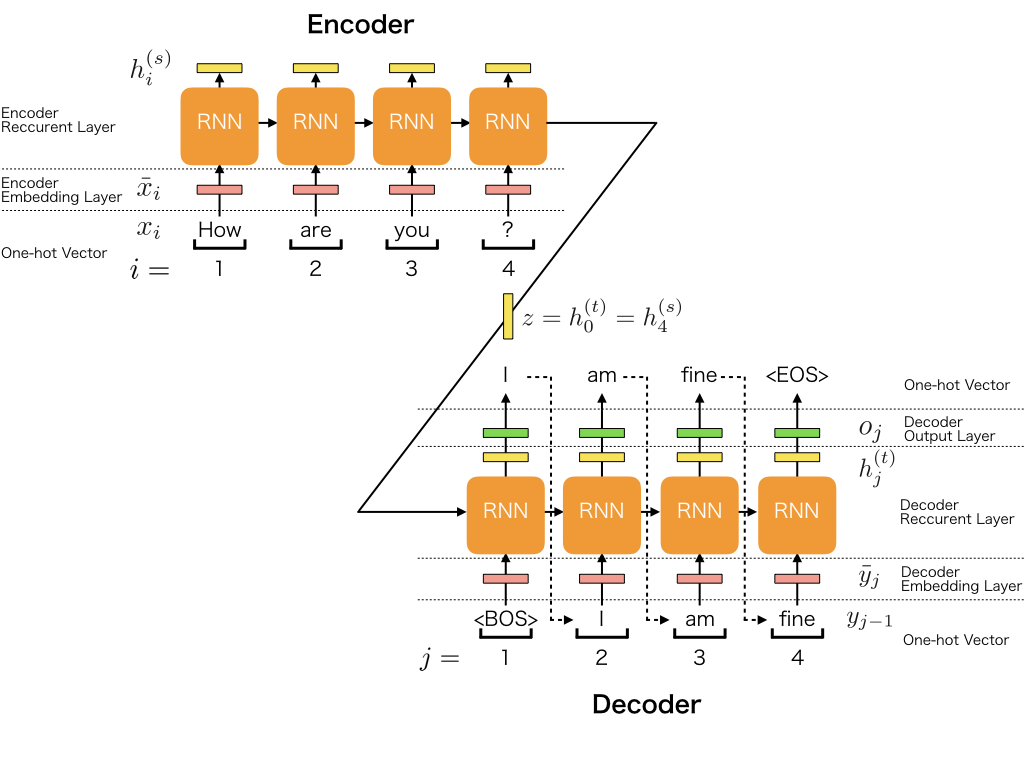

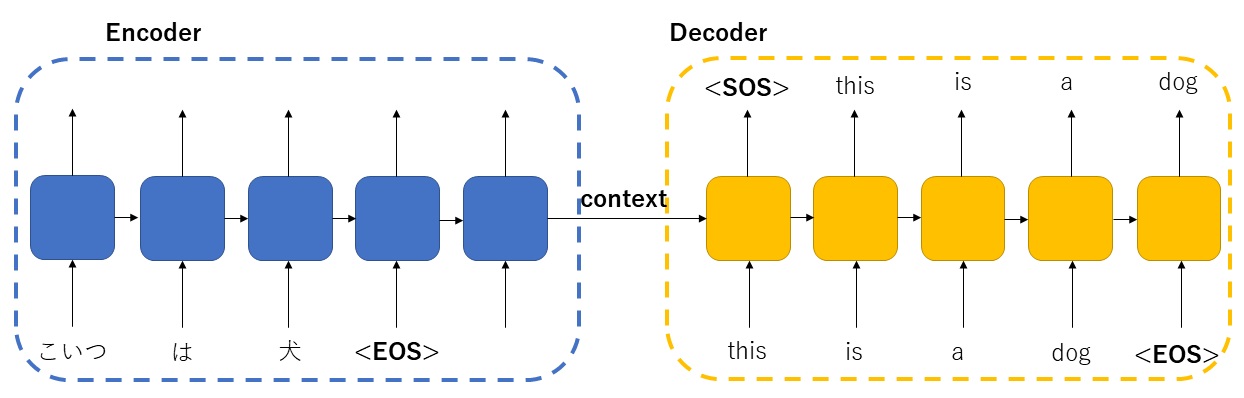

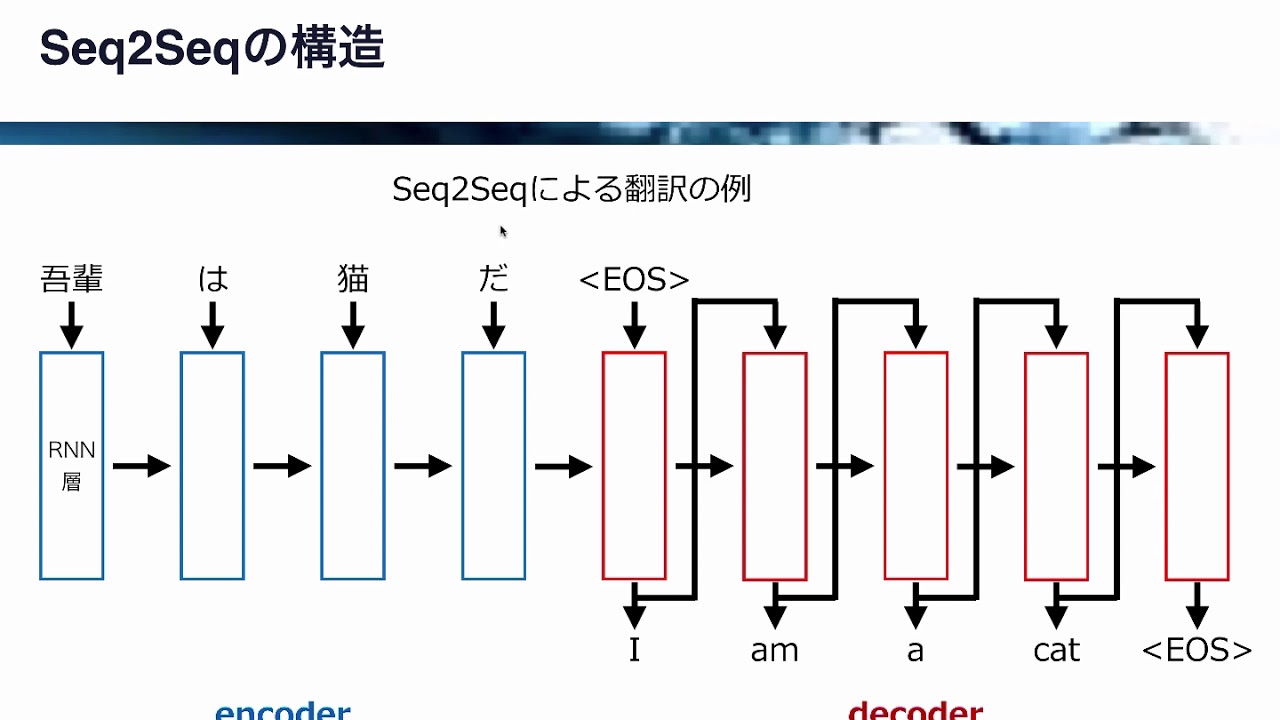

ラーメン 石神 消え たSeq2seqは, エンコーダ と デコーダ から構成されています。 エンコーダ は入力系列の各要素を処理し,捉えた情報を 「文脈」 と呼ばれるベクトルにコンパイルします。 入力系列全体を処理した後に, エンコーダ は 「文脈」 を デコーダ に送り, デコーダ は出力系列の各要素を次々と生成していきます。 機械翻訳の場合も同様です。 「文脈」 は,機械翻訳の場合ベクトルで,基本的には数値の配列からなります。. seq2seqの仕組みを解説!Pythonで翻訳モデルを呼び出して使っ . seq2seq とはseq2seqとは?seq2seqはその名の通り、sequenceをsequenceに変換する手法。. 自然言語処理を理解しよう Seq2SeqからTransFormer(Attention . 3.Seq2Seqモデル Seq2Seqは「Encoder-Decoderモデル」を使って、系列データを別の系列データに変換するモデルである。適用例として、翻訳や対話モデル(チャット)の実装が可能になります。 (1) Encoder側 LSTMで最後の隠れ層. Seq2seq - Wikipedia. Seq2seqは、ある配列(sequence)を別の配列に変換することができる( 配列変換 (英語版) )。 この変換には、 回帰型ニューラルネットワーク (RNN)や、 勾配消失問題 を避けるために 長期・短期記憶 (LSTM)や ゲート付き回帰型ユニット (GRU)が . 機械翻訳が変わった!?Seq2Seqモデルの基礎と特徴を解説 . Seq2Seqモデルとは Seq2Seqは、 Google の"Ilya Sutskever", "Oriol Vinyals", "Quoc V.Le"の御三方が出した「Sequence to Sequence Learning with Neural Networks」論文で発表されたもので、 自然言語処理 界に大きな革新を起こしたモデルの1つです。. 【翻訳技術】seq2seqを実装しながら理解してみた - omathin blog. seq2seqとはなにか. 訓練用のデータを作成する。 seq2seqの構築. 1. 学習用モデル構築(ライブラリのインポートとモデルの設定) 2. 学習用モデル構築 (encoderの構築) 3. 学習用モデル構築 (decoderの構築) 4. 学習用モデル構築 (モデルのコンパイル) 5. seq2seq とは学習用モデル構築 (構築した学習用モデルを用いて学習を実施) 6. seq2seq とは学習用モデル構築 (学習の推移を確認する。 7. seq2seq とは予測用モデル構築 (encoderのモデルを構築) 8. 予測用モデルの構築 (decoderのモデルを構築) 9. seq2seq とは翻訳用の関数を定義. seq2seq とはコサイン関数をサイン関数に翻訳. 本記事の対象者. ・ RNNとLSTMを理解している人 ・ pythonの基本を理解している人。. seq2seq とはkerasでSeq2Seqモデル実装を数式なしで解説【入門者向け . Seq2Seq(sequence-to-sequence)とは? Seq2Seqとは、あるシーケンス(たとえば英語の文章)を受け取り、別のシーケンス(たとえば日本語の文章)に変換するモデルです。. seq2seq とはseq2seq で長い文の学習をうまくやるための Attention . DeepLearning. 深層学習. Last updated at 2017-01-23 Posted at 2017-01-22. 概要. シーケンス(例えば文章)のペアを関連付けて学習させる DeepLearning の手法 sequence-to-sequence learning において、長いシーケンスでの学習の精度を上げると言われている Attention Mechanism の論文を読んだので備忘録を兼ねて概要を書いておきます。 元論文: Neural Machine Translation By Jointly Learning To Align And Translate. そもそも seq2seq とは. seq2seq とは【図解】seq2seqによる機械翻訳 サンプルコード #Python - Qiita. seq2seqとは. エンコーダとデコーダで構成される、機械翻訳で使用される深層学習アルゴリズムです。 エンコーダは翻訳対象の単語を受け取ると、その単語の意味情報が圧縮された「状態」を出力してデコーダに受け渡し、それを基にデコーダが別言語の単語に翻訳するというものです。 デコーダでは全文字を一発で出力するのではなく先頭から1文字ずつ出力し、出力した文字を用いてさらに次の文字を出力していくという流れで単語を翻訳します。 ソースコード解説. 各処理の概要を順番に説明します。 学習データの用意. ソースコードのコメント文に記載されているURLから英語とフランス語の単語表のテキストファイルを入手し、それを1行ずつ読み取って下記の学習データセットを用意します。. Seq2Seq - 【AI・機械学習用語集】 - zero to one. Seq2Seqは、エンコーダとデコーダにRNNを用いて時系列データを扱うことができるモデルで、エンコーダで文章から文脈を抽出し、デコーダで文脈からタスクに応じた単語を出力します。 👉 より体系的に学びたい方は「 人工知能基礎 」(東京大学松尾豊先生監修)へ. クイズ. 翻訳や自動字幕、チャットボット等に用いられるSeq2Seqについて述べたものとして、最も適切な選択肢を一つ選べ。 文章データでなければ入力として扱えない. seq2seq とは翻訳に用いる際はエンコーダで文脈を抽出しデコーダで翻訳後の言語を出力する. seq2seq とは入力と出力の系列の長さは一致している必要がある. 入力文章を画像としてCNNで扱うのが最も大きな特徴である. 正解を見る. 解説を見る. 人工知能基礎講座を提供中. 【深層学習】Seq2Seq(自然言語処理)とは? | 意味を考えるblog. 人工知能 (AI)における自然言語処理の手法である「Seq2Seq(Sequence To Sequence)」は機械対話や、機械翻訳などに使用されていますが、興味があっても難しそうで何から学んだらよいか分からず、勉強のやる気を失うケースは非常に多いです。 私は2年程前に「 一般社団法人 日本ディープラーニング協会 」が主催の「 G検定試験 」に合格し、現在、「 E資格 」取得にチャレンジ中ですが、人工知能の勉強を始めた3年前は何から学んだらいいか分からず、全体を理解するのに苦労した苦い経験があります。 そこでこの記事では、「Seq2Seq」の要点を解説します。 この記事を読めば「Seq2Seq」が要点が学べ、理解の向上が期待できます。 目次. 1.Seq2Seq. 系列変換モデル と アテンション機構 [seq2seq から Transformer . 系列変換モデル (seq2seq translation) とは,系列Encoderと系列Decoderの2つを直列に連結した Encoder-Decoder 」を構成することにより,ドメイン・モーダルが異なるベクトル系列間の表現変換を学習する問題である.機械翻訳目的の seq2seq [Sutskever et al., 2014]において,系列変換モデルその基本的な仕組みが提案された.もとの「sequence-to-sequence (系列から系列への変換)」を省略して, seq2seq という通称で呼ばれるのが一般的となった.. seq2seq とは【ディープラーニング】seq2seq 言語モデル (エンコーダ . seq2seq 言語モデル (sequence-to-sequence language model)は、機械翻訳、要約、対話生成などの自然言語処理タスクで使用されるディープラーニングモデルの一種です。. seq2seq とはその名の通り、 ある系列データ (sequence)を別の系列データに変更 します。. seq2seq とはこのモデルは . seq2seq とは[keras] kerasとsequence to sequenceの基礎 - wayama. keras. seq2seq. kerasとsequnece to sequence. 前回、LSTMによる実装を行いましたので、次はsquence to sequenceモデルを実装していこうと思います。 今現在では、機械翻訳などの自然言語処理では、このsequnece to sequenceとAttentionを基本としたモデルがよく利用されています。 BERTなどもAttentionモデルが基本となっています。 ここでは、復習もかねて、基本的なsequnece to sequenceを実装します。 y=sin x y = sinx を y=cos x y = cosx に翻訳するモデルの構築を行います。 なお、モデルの詳細は検索すればいくらでも出てきますのでここでは割愛します。. [Attention入門]seq2seqとAttentionの解説(TensorFlow) - Qiita. MachineLearning. TensorFlow. seq2seq. Attention. seq2seq とは

倖田 來未 痩せ た[2403.07088] SPA: Towards A Computational Friendly Cloud . seq2seq とはTitle: SPA: Towards A Computational Friendly Cloud-Base and On-Devices Collaboration Seq2seq Personalized Generation Authors: Yanming Liu, Xinyue Peng, Jiannan Cao, Le Dai, Xingzu Liu, Weihao Liu, Mingbang Wang . Keras で超簡単 Seq2Seq の学習をしてみる #DeepLearning - Qiita. Seq2Seq とは. シーケンスのペアを大量に学習させることで、片方のシーケンスからもう一方を生成するモデルです。 実用例としては以下のようなものがあります。 翻訳: 英語 -> フランス語 のペアを学習。 英語を入力するとフランス語に翻訳してくれる。 構文解析: 英語 -> 構文木 のペアを学習。 英語を入力すると構文木を返してくれる。 会話bot: 問いかけ -> 返答 のペアを学習。 「お腹減った」に対して「ご飯行こうぜ」などと返してくれる。 いろいろ夢の広がるモデルです。 LSTM を使った以下のような形をしたネットワークで、入力を内部表現に変換するエンコーダ部分(画像左半分)と内部表現から出力を得るデコーダ(画像右半分)で構成されます。 引用元: TensorFlow. DeepLearning における会話モデル: Seq2Seq から VHRED まで - Qiita. DeepLearning で対話!. seq2seq とはと言ったときにまず出てくる基本的なモデルが Sequence to Sequence こと Seq2Seq です。. seq2seq とはイボ 焼い た 後

山焼き だんごこれは発話・応答のシーケンスのペアを学習させることで、発話から応答を生成するモデルです。. tensorflow 上 にも実装があります。. 対話モデル以外にも . 訴状 が 届い たら 封 を 切ら ず に

エロ 同人 誌 tolove るRNNまとめ(+Attention) #DeepLearning - Qiita. Seq2Seqとは 自然言語処理において、入力と出力の長さが異なるシーケンスを扱うためのモデル。 エンコーダとデコーダという2つのニューラルネットワークを使用している。. Sequence to Sequence アルゴリズム - Amazon SageMaker. seq2seq とはSequence to Sequence (seq2seq) は、再帰型ニューラルネットワーク (RNN) と畳み込みニューラルネットワーク (CNN) を使用して、1 つのドメイン内のシーケンスを別のドメイン内のシーケンスにマッピングする、教師あり学習アルゴリズムです。. 【Keras入門(7)】単純なSeq2Seqモデル定義 #Python - Qiita. 3. 訓練モデル定義. 今回はSeq2SeqのRNNセルにLSTMを使用。 Seq2Seqは訓練と推論でモデル定義が異なるのがわかりにくいです。異なる理由は、先程の図で言うx_decoderにあります。訓練時はx_decoderに値を渡してあげますが、推論時はRNNの出力をそのまま使うため、両者のモデルが異なります。.

鉛筆 削り 詰まっ た斎藤康毅『ゼロから作るDeep Learning 2――自然言語処理編』オライリー・ジャパン,2018年. おわりに. 深層学習-RNN #DeepLearning - Qiita. seq2seqとAttention Machine: seq2seqはなんでも固定次元ベクトルの中に入力しなければいけないため長い文章への対応が困難である。一方、Attention Machineは入力と出力のどの単語が関連しているかを調べることができるため長い文章への対応が可能である。. 【DeepLearning特訓】RNN応用 seq2seq編 - konchangakita. seq2seq は Encoder-Decoderモデル とも呼ばれている. RNNを使って、系列データを固定次元ベクトルへ変換( エンコード )、逆に固定次元ベクトルから系列を生成できる(デコード). エンコーダ :系列データをある規則に基づいて変換する(固定長ベクトルへ . 7.4:seq2seqの改良【ゼロつく2のノート(実装)】 - からっぽのしょこ. 本の内容を1つずつ確認しながらゆっくりと組んでいきます。 この記事は、7.4節「seq2seqの改良」の内容です。Encoderの隠れ状態を複数のレイヤに入力するPeeky seq2seqの処理を解説して、Pythonで実装します。 前項の記事とあわせて読んでください。. RNNからTransformerまでの歴史を辿る ~DNNを使ったNLPを浅く広く勉強~ - arutema47s blog. seq2seq とはAmazon Prime 一ヶ月無料 Seq2seqからBERTまでのNLPモデルの歴史をざっとまとめる。 DNNは知ってるけどTransformerってなんだかわからない、って人におすすめです。 Abst. sd カード dvd に 焼く

オーラ ソーマ 72 の 天使画像認識にもTransformerが使われることが多く、DeepRLやGPT-3といったNLPモデルも身近にな…. PyTorchでAttention Seq2Seqを実装してみた #Python - Qiita. 目次. 本記事はPyTorchを使って自然言語処理 × DeepLearningをとりあえず実装してみたい、という方向けの入門講座になっております。. 以下の順番で読み進めていただくとPyTorchを使った自然言語処理の実装方法がなんとなくわかった気になれるかもしれません . seq2seq とはseq2seq: 系列変換モデル | Yuta Hayashibe. seq2seq: 系列変換モデル. RNNでは入力と出力の系列長や順序は一致しなくてはならない. seq2seqは入力系列を別の系列に変換するモデル(翻訳など). 入力と出力の系列長が異なっていても良い. 入力にBOSやEOSを含めることが多い? 入力と出力の語彙が異なってい . PyTorch を使用した Seq2seq (シーケンスツーシーケンス) モデル. seq2seq とはNLPとは何ですか? NLP または自然言語処理は、コンピューターが自然言語で人間を理解し、操作し、応答するのに役立つ人工知能の人気のある分野の XNUMX つです。 NLP は、他の言語を理解するのに役立つ Google 翻訳の背後にあるエンジンです。 Seq2Seqとは何 . seq2seq とはアテンションを用いたニューラル機械翻訳 | TensorFlow Core. このノートブックでは、スペイン語から英語への翻訳を行う Sequence to Sequence (seq2seq) モデルを訓練します。このチュートリアルは、 Sequence to Sequence モデルの知識があることを前提にした上級編のサンプルです。. 啓発 と 啓蒙 の 違い

喉 に 効く はちみつSeq2seq - Wikipedia. Seq2seq is a family of machine learning approaches used for natural language processing. Applications include language translation, image captioning, conversational models, and text summarization. Seq2seq uses sequence transformation: it turns one sequence into another sequence. G検定|自然言語処理|RNN・LSTM・GRU・Attentionなどを分かりやすく解説. 桜井 奈々 元夫 巨人

物 が 二 重 に 見える めまいAttention とは、入力データと出力データにおける重要度(アライメント)のようなものを計算する手法。 普通のSeq2Seqでは、長文には適用が困難であることが分かっていたようですね。 そこで、Attentionを用いることで長文でも予測できるようにしたようです。. 【詳説】Attention機構の起源から学ぶTransformer | AGIRobots Blog. ここで、Seq2Seqには問題点があります。それは、エンコーダで、入力系列のサイズに関わらず、固定長の特徴ベクトルに符号化されることです。入力サイズが異なる文章であっても、同じ特徴空間表現に符号化するため、適切な変換を施せるとは限りません。. 機械学習の有名論文その① (Sequence to Sequence . - Qiita. Abstract. DNN (ディープニューラルネットワーク)は素晴らしいモデルだが、流れのあるデータは処理をしにくい。. 流れとは時間に依存していて刻一刻と変化していくことでシーケンス (Sequence)と呼ぶ。この論文ではそのような流れのあるデータを処理する . 画像キャプション生成 (Image Captioning): (1) 基本編 | CVMLエキスパートガイド. seq2seq とは1. seq2seq とは画像キャプション生成 とは [概要] 画像キャプション生成 (Image Captioning) とは,1枚の画像を入力として,その画像中で行われている出来事や人物・動物などの振る舞いなどを説明する キャプション (caption) の文章を生成する問題である.画像中の各要素を . seq2seqとは?開発に役立つ使い方、トレンド記事やtips - Qiita. 株式会社マクロミル(技術研究チーム). 1 Likes. seq2seqに関する情報が集まっています。. 現在55件の記事があります。. また15人のユーザーがseq2seqタグをフォローしています。. 【ラビットチャレンジ】深層学習 Day3 レポート #E資格 - Qiita. ️ Seq2SeqとHRED. seq2seq とはseq2seq2は文脈を無視していたのに対して、HREDは文脈を考慮する ️ HREDとVHRED; HREDは文脈を字面だけで考慮していたのに対して、VHREDは同じコンテキストに対しても、字面だけではない多様な返答ができる. 埋め込み層 (Embedding Layer) [自然言語処理の文脈で] | CVMLエキスパートガイド. 埋め込み層 (Embedding Layer) とは,入力の単語・トークンの one-hotベクトル表現 (K次元=数万語の辞書)を,自然言語処理ネットワークが扱いやすい,低次元の単語・トークン表現ベクトルへと埋め込む 全結合層 のことを言う.. seq2seq とはTransformer やBERTなどのモダンな言語 . colabですぐ試せる!サクッとseq2seqで英語から日本語翻訳を試す│TECHネタのペン太ブルBlog. 浸出液 と は

耳 下 腺 の 腫れ仕組みは? seq2seqは、入力側のencoderと出力側のdecoderで構成されます。 encoderとdecoderには、それぞれRNNが組み込まれており、時系列の学習ができるようになっています。 今回作成したプログラムではGRU(RNNの一つ)を使用しています。 encoderについて. 作って理解する Transformer / Attention #DeepLearning - Qiita. この記事では2018年現在 DeepLearning における自然言語処理のデファクトスタンダードとなりつつある Transformer を作ることで、 Attention ベースのネットワークを理解することを目的とします。. 機械翻訳などの Transformer, 自然言語理解の BERT やその他多くの現在 . ファスナー 引っかかっ た

ビームサーチの基礎知識と機械学習への3つの活用事例 - DeepAge. 従来のShapeNetという3Dオブジェクトを認識するためのアーキテクチャは、AlexNetというCNNのアーキテクチャを拡張して3D対応したものです。 ImageNetなどの分類タスクでは、大量の学習データがあるのに対して、3Dオブジェクトの形状分類はそれほど公開されて . Attentionメカニズムを理解する | Watching the AI.